PaddleRS:无人机汽车识别

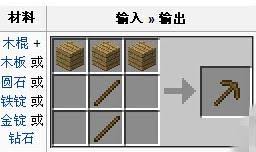

该项目基于PaddleRS,利用0.05米分辨率的DFC2018 Houston数据集超高分辨率影像,裁剪出1400张图块并标注汽车,按9:1划分训练集和验证集。通过定义数据增强和数据集,使用PPYOLOv2模型训练,借助VDL查看效果,评估得较高map,最后实现模型预测及可视化。

PaddleRS:无人机汽车识别

基于0.5m的高分辨率无人机影像,我们希望能够使用目标检测的方法找到影像中的汽车。项目将基于PaddleRS完成该任务。

1 数据准备

数据来自于DFC2018 Houston,DFC2018 Houston 是2018年IEEE GRSS Data Fusion 比赛所用的数据集。这个数据是由 University of Houston Dr. Saurabh Prasad 的实验室制作公开的。这个数据是个多传感器数据,包含了48个波段的高光谱数据(1米),3波段的LiDAR数据(0.5米),以及超高分辨率影像(0.05米)。这个数据包含了20类地物。

只取用了其中0.05米分辨率的超高分辨率影像,裁剪为1400张596x601大小的图块,由手工标注汽车的矩形框,按照9:1划分训练集和数据集。

In [1]# 解压数据集! mkdir -p dataset! unzip -oq data/data56250/carDetection_RGB.zip -d dataset登录后复制 In [2]

# 划分数据集import osimport os.path as ospimport randomdef get_data_list(data_dir): random.seed(666) mode = ["train_list", "val_list"] dir_path = osp.join(data_dir, "JPEGImages") files = [f.split(".")[0] for f in os.listdir(dir_path)] random.shuffle(files) # 打乱顺序 with open(osp.join(data_dir, f"{mode[0]}.txt"), "w") as f_tr: with open(osp.join(data_dir, f"{mode[1]}.txt"), "w") as f_va: for i, name in enumerate(files): if (i % 10) == 0: # 训练集与测试集为9:1 f_va.write(f"JPEGImages/{name}.jpg Annotations/{name}.xml\n") else: f_tr.write(f"JPEGImages/{name}.jpg Annotations/{name}.xml\n") labels = ["car"] txt_str = "\n".join(labels) with open((data_dir + "/" + f"label_list.txt"), "w") as f: f.write(txt_str) print("Finished!")get_data_list("dataset")登录后复制 Finished!登录后复制

2 PaddleRS准备

PaddleRS是基于飞桨开发的遥感处理平台,支持遥感图像分类,目标检测,图像分割,以及变化检测等常用遥感任务,帮助开发者更便捷地完成从训练到部署全流程遥感深度学习应用。

github:https://github.com/PaddlePaddle/PaddleRS

接下来可以通过git clone得到PaddleRS。

In [7]! git clone https://github.com/PaddlePaddle/PaddleRS.git%cd PaddleRS! git checkout release/1.0! pip install --upgrade pip! pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple! python setup.py install%cd ..登录后复制

3 模型训练

PaddleRS借鉴PaddleSeg的API设计模式并进行了较高程度的封装,可以方便的完成数据、模型等的定义,快速开始模型的训练迭代。

3.1 数据定义

主要通过datasets和transforms两个组件完成任务,datasets中有包含分割检测分类等多任务的数据加载API,而transforms集成了大部分通用或单独的数据增强API,目前可以通过源码查看。

In [2]import osimport os.path as ospfrom paddlers.datasets import VOCDetDataset from paddlers import transforms as T# 定义数据增强train_transforms = T.Compose([ T.DecodeImg(), T.RandomDistort(), T.RandomCrop(), T.RandomHorizontalFlip(), T.BatchRandomResize( target_sizes=[512, 544, 576, 608, 640, 672, 704], interp='RANDOM'), T.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]), T.ArrangeDetector('train')])eval_transforms = T.Compose([ T.DecodeImg(), T.Resize(target_size=608, interp='CUBIC'), T.Normalize( mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]), T.ArrangeDetector('eval')])# 定义数据集data_dir = "dataset"train_file_list = osp.join(data_dir, 'train_list.txt')val_file_list = osp.join(data_dir, 'val_list.txt')label_file_list = osp.join(data_dir, 'label_list.txt')train_dataset = VOCDetDataset( data_dir=data_dir, file_list=train_file_list, label_list=label_file_list, transforms=train_transforms, shuffle=True)eval_dataset = VOCDetDataset( data_dir=data_dir, file_list=train_file_list, label_list=label_file_list, transforms=eval_transforms, shuffle=False)登录后复制 2024-03-08 18:57:32 [INFO]Starting to read file list from dataset...2024-03-08 18:57:39 [INFO]944 samples in file dataset/train_list.txt, including 944 positive samples and 0 negative samples.creating index...index created!2024-03-08 18:57:39 [INFO]Starting to read file list from dataset...2024-03-08 18:57:47 [INFO]944 samples in file dataset/train_list.txt, including 944 positive samples and 0 negative samples.creating index...index created!登录后复制 In [5]

# 检查及可视化数据import numpy as npimport cv2import matplotlib.pyplot as plt%matplotlib inline# 反归一化def in_normal(img): mean = np.array([0.485, 0.456, 0.406]) std = np.array([0.229, 0.224, 0.225]) img = (255 * (img * std + mean)).astype("uint8") return img# 绘制矩形框def visual(img, bboxs): for bbox in bboxs: x1, y1, x2, y2 = bbox cv2.rectangle(img, (x1, y1), (x2, y2), (255, 0, 0), 2) return imgfor data in train_dataset: img = in_normal(data["image"]) vis = visual(img, data["gt_bbox"]) plt.figure(figsize=(10, 10)) plt.imshow(img) plt.show() break登录后复制 登录后复制登录后复制

3.2 模型准备

PaddleRS将模型分别放置于models和custom_models中,分别包含了Paddle四大套件的模型结构以及与遥感、变化检测等相关的模型结构。通过tasks进行了模型的封装,集成了Loss、Opt、Metrics等,可根据需要进行修改。这里以默认的PPYOLOv2为例。

In [7]from paddlers.tasks.object_detector import PPYOLOv2num_classes = len(train_dataset.labels)model = PPYOLOv2(num_classes=num_classes)登录后复制 In [ ]

model.train( num_epochs=30, train_dataset=train_dataset, train_batch_size=16, eval_dataset=eval_dataset, pretrain_weights="COCO", learning_rate=3e-5, warmup_steps=10, warmup_start_lr=0.0, save_interval_epochs=5, lr_decay_epochs=[10, 20], save_dir="output", use_vdl=True)登录后复制

训练的效果可以通过VDL进行查看。

from paddlers.tasks import load_modelnew_model = load_model("output/best_model")登录后复制 2024-03-08 19:28:24 [INFO]Model[PPYOLOv2] loaded.登录后复制

4 模型评估

只需要调用evaluate即可完成预测。可以看到map还是挺高的。

In [10]new_model.evaluate(eval_dataset)登录后复制

2024-03-08 19:28:32 [INFO]Start to evaluate(total_samples=944, total_steps=944)...2024-03-08 19:29:17 [INFO]Accumulating evaluatation results...登录后复制

OrderedDict([('bbox_map', 90.35561807270788)])登录后复制 5 模型预测

PaddleRS的目标检测task可以方便的给出坐标、类别和分数,可供自行进行一些后处理。也可以直接使用visualize_detection进行可视化。下面对一张测试图像进行预测并可视化。

In [11]from paddlers.tasks.utils.visualize import visualize_detectionimport matplotlib.pyplot as plt%matplotlib inlinetest_transforms = T.Compose([ T.DecodeImg(), T.Resize(target_size=608, interp='CUBIC'), T.Normalize( mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]), T.ArrangeDetector('test')])img_path = "dataset/JPEGImages/UH_NAD83_272056_3289689_58.jpg"pred = new_model.predict(img_path, test_transforms)vis_img = visualize_detection(img_path, pred, save_dir=None)plt.figure(figsize=(10, 10))plt.imshow(vis_img)plt.show()登录后复制 登录后复制登录后复制

免责声明

游乐网为非赢利性网站,所展示的游戏/软件/文章内容均来自于互联网或第三方用户上传分享,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系youleyoucom@outlook.com。

同类文章

AI驱动存储芯片市场爆发,2027年或达3000亿规模

全球存储芯片市场正经历一场由人工智能(AI)需求主导的深刻变革。摩根大通分析师团队在最新报告中指出,云服务提供商对高性能内存的旺盛需求,正推动整个行业进入长期结构性增长通道。这场变革不仅重塑了DRA

真我GT8 Pro首发2K 144Hz京东方直屏

9月26日消息,真我realme官方正式宣布,真我GT8 Pro将联合京东方全球首发2K 144Hz“苍穹屏”,官方将其定位为“神级

OPPO Find X9首发4K实况照片 影像体验再升级

9月26日消息,OPPO宣布其全新Find X9系列手机将全球首发“直出4K超清实况照片”功能,这一创新技术标志着手机影像领域的一次

vivo X300系列重构移动影像体验,全链路创新开启场景化创作新时代

9月26日,vivo在“X系列蓝图影像技术沟通会”上揭晓全新影像战略,宣布以“场景解决方案”为核心构建开放生态,推动移动影像从工具属

OPPO Find X9红色限定版亮相,绒砂工艺重塑高端质感

9月26日消息,OPPO官方微博发布了全新的产品外观图,其中Find X9系列红色特别版首次亮相。这款采用全新红色设计的旗舰新机,以

相关攻略

热门教程

更多- 游戏攻略

- 安卓教程

- 苹果教程

- 电脑教程