中科院联合清华发布VLA-R1模型:机器视觉语言行动推理新突破

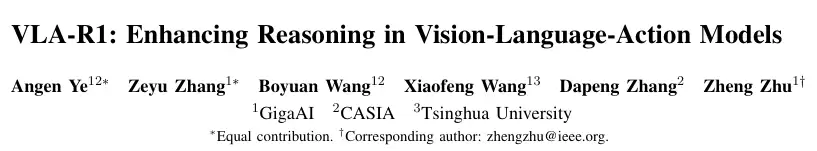

刚刚,中科院自动化所、清华和GigaAI联合发布视觉-语言-行动(Vision-Language-Action, VLA)模型的R1推理版本。让机器人实现了先思考再行动。

还记得 DeepSeek R1吗?它实现了大语言模型先思考再回答。

刚刚,中科院自动化所、清华和GigaAI联合发布视觉-语言-行动(Vision-Language-Action, VLA)模型的R1推理版本。让机器人实现了先思考再行动。

当前的机器人模型在执行任务时,像一个提线木偶,直接输出动作,而VLA-R1模型给机器人装上了一个会推理的大脑,让它在行动前先想清楚每一步。

视觉-语言-行动(Vision-Language-Action, VLA)模型是具身智能(embodied AI)领域的一项关键技术。它的目标是让一个智能体,比如机器人,能够像人一样,通过看(视觉)、听(语言)来理解指令,并作出相应的行动。

这就像你告诉一个朋友,请把桌上的红苹果递给我。他会先用眼睛扫描桌子,找到所有的苹果,分辨出红色的那个,然后规划手臂的运动路径,最后伸手拿起并递给你。这个过程融合了感知、理解、推理和行动。

早期的VLA模型已经能做到不错的程度。它们通过学习海量的图片与文字,建立了对世界的基本认知。比如,它知道什么是苹果,什么是桌子。接着,通过学习大量的操作数据,它将这种认知与具体的机器人动作联系起来。比如,它学会了如何控制机械臂去抓取一个物体。

这使得模型具备了宝贵的泛化能力。即使它没见过某个特定品牌的杯子,但因为它理解‘杯子’这个概念,它也能举一反三,去抓取那个新杯子。它还能理解组合性的新指令,比如‘把方块放到圆圈的左边’。

然而,这些模型有一个共同的短板,它们像一个做事不过脑子的行动派。

你给它一个指令,它几乎是凭直觉,直接给出一个最终动作。这个过程像个黑箱,中间没有清晰的思考步骤。它不会明确地去推理物体的用途(可供性),比如杯子是用来装水的,锤子是用来敲的。它也不会仔细分析物体之间的几何关系,比如哪个物体在前面,哪个在后面。

这种莽撞的模式,在简单的场景下或许还能应付。一旦环境变得复杂,问题就暴露无遗。

想象一下桌上有两个颜色非常接近的红色方块,指令是‘拿起那个深红色的方块’。模型很可能因为无法进行细致的推理而选错。

再比如,桌上有好几个碗,指令是‘把草莓放进碗里’。模型应该选择哪个碗?是离得最近的,还是最大的,还是空的那个?缺乏推理能力,模型的选择就带有很大的随机性,任务成功率自然大打折扣。

更关键的是,现有的模型训练方法也难以系统性地提升这种推理能力。主流的方法是监督微调(supervised fine-tuning, SFT)。就是给模型看大量的‘问题-标准答案’,让它去模仿。这种方式很少能优化思考过程的质量,也缺乏对最终执行效果的有效奖励。

即便引入了强化学习(Reinforcement Learning, RL),奖励设计也通常很单一,比如只奖励最终任务是否成功。这很难同时优化过程的合理性(比如视觉区域对齐是否准确)和动作的连贯性(比如轨迹是否平滑)。这导致模型在面对新环境或真实世界时,性能会大幅下降。

机器人需要学会思考。不是简单的反应,而是有条理、有逻辑的逐步推理。

VLA-R1学会了先思考再行动

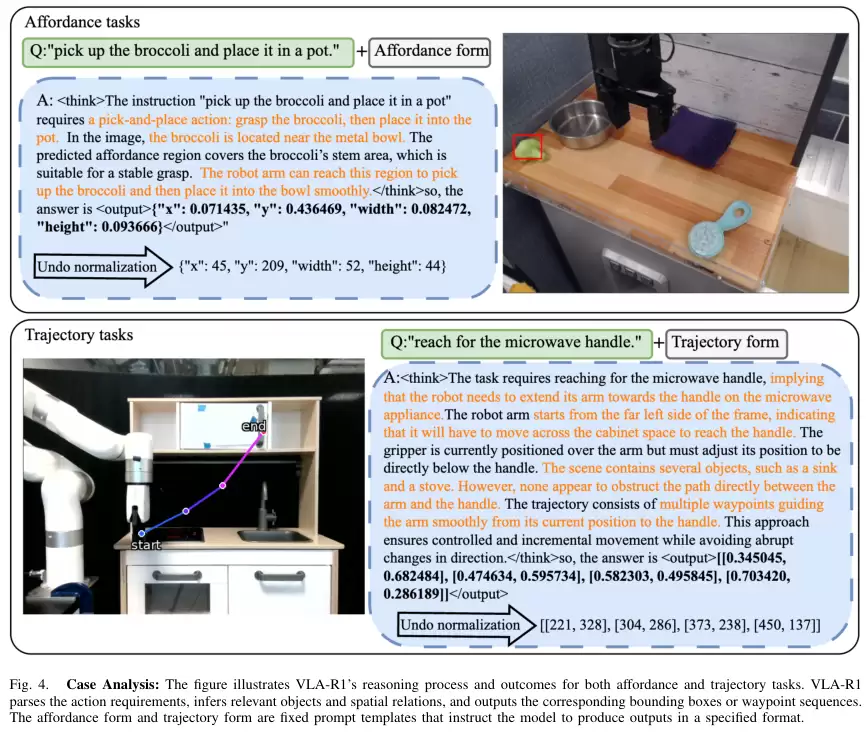

针对这些挑战,研究人员提出了VLA-R1,一个会推理的VLA模型。它的核心思想很简单:把人的思考过程,也就是思维链(Chain-of-Thought, CoT),教给模型,并用一套可验证的奖励机制去强化这个思考过程和最终的行动。

这全面提升了机器人行动的准确性。

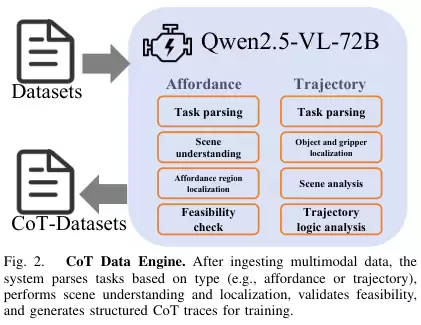

整个VLA-R1的训练和工作流程分为两个核心阶段。

第一阶段是学习如何思考。这个阶段采用的是监督微调。

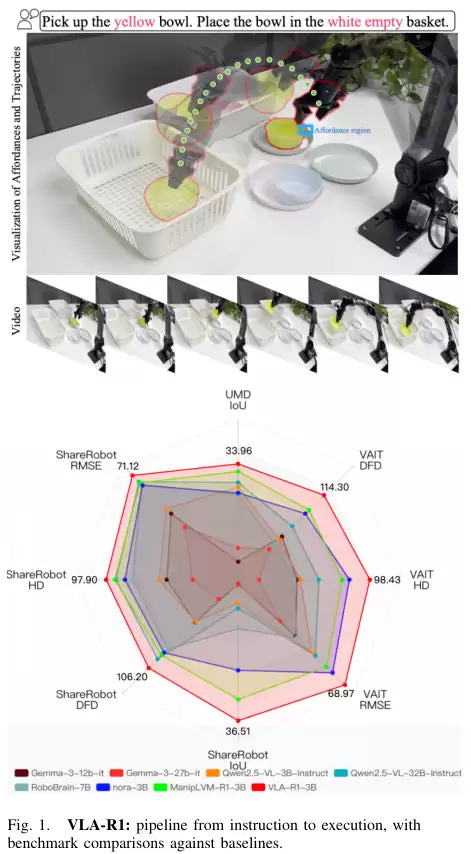

研究团队首先需要高质量的教材,也就是带有清晰思考过程的训练数据。他们构建了一个名为VLA-CoT-13K的数据集。他们使用强大的Qwen2.5-VL-72B模型,为13000个任务场景自动生成了中间的推理步骤。

比如,对于‘把绿色的积木放到红色的碗里’这个任务,生成的思维链可能是这样的:

识别任务目标:移动绿色积木。定位绿色积木:在图像的左上角区域找到了一个绿色的方块。识别目的地:红色的碗。定位红色的碗:在图像的右侧中间位置找到了一个红色的碗。规划行动轨迹:从绿色积木的位置,规划一条避开障碍物的路径,移动到红色碗的上方,然后放下。这些带有思维链的数据,就像一本本详细的解题步骤分析。模型在学习时,不仅仅是看到最终答案(机器人动作),更重要的是学习了从问题到答案的整个逻辑推理过程。这种‘先推理,后行动’的策略,让模型学会了分解任务,将视觉感知和最终的动作目标更紧密地联系起来,也大大提高了学习效率。

在模型架构上,VLA-R1使用Qwen2.5-VL-3B作为基础。它的视觉部分是一个经过重新设计的视觉Transformer,可以高效处理高分辨率图像和视频。语言部分则使用了成熟的Qwen2.5解码器。图像和文字信息在这里融合,共同推理,最终生成包含推理过程和动作预测的结构化输出。这个输出随后被转换成机器人可以执行的连续7D动作指令(包括三维空间位移,三维旋转和夹爪的开合)。

第二阶段是强化思考与行动的质量。这个阶段采用的是强化学习。

经过第一阶段的学习,模型已经初步具备了推理能力。但这种推理可能还不够精确,不够鲁棒。就像一个学生学会了解题步骤,但计算过程可能还会有小错误。

为了解决这个问题,研究团队引入了一套基于可验证奖励的强化学习(Reinforcement Learning from Verifiable Rewards, RLVR)策略。他们采用了一种名为群体相对策略优化(Group Relative Policy Optimization, GRPO)的算法。这个算法的好处是,可以让模型从结构化的、可验证的奖励中学习,同时保持训练过程的稳定。

研究团队设计了三种具体的、可量化的奖励,像三位严格的考官,从不同维度评判模型的输出。

第一位考官负责评判轨迹。它使用的评分标准叫作角度长度增强Fréchet距离(Angle-Length Augmented Fréchet distance,ALAF)。传统的评价方式可能是比较两个轨迹对应点之间的距离,但ALAF更聪明。它不仅考虑位置,还考虑了轨迹的顺序、方向和局部长度。

第二位考官负责评判空间定位的准确性。比如指令是‘拿起那个苹果’,模型需要先在图像中框出苹果的位置。这位考官使用的评分标准是广义交并比(Generalized Intersection over Union,GIoU)。交并比(IoU)是衡量两个边界框重合度的常用指标。但当两个框完全不重合时,IoU为0,无法反映它们之间的距离。GIoU则改进了这一点,即使两个框不重合,它也能通过计算包裹它们的最小外接矩形来给出一个惩罚,从而衡量它们的距离。

第三位考官负责评判输出格式。它要求模型的输出必须严格遵守‘先推理,后动作’的结构。输出必须先包含一段推理文字,然后是一个被特定标签(...)包裹的动作指令。

通过这三位考官的联合评分,模型不断调整自己的策略,力求在轨迹对齐、空间定位和格式规范性上都做到最好。这个过程系统性地优化了模型的推理鲁棒性和执行准确性。

严苛的考验证明了它的强大

为了验证VLA-R1的真实水平,研究团队设计了一系列严格的实验,涵盖了从标准数据集到模拟环境,再到真实世界的全方位考验。

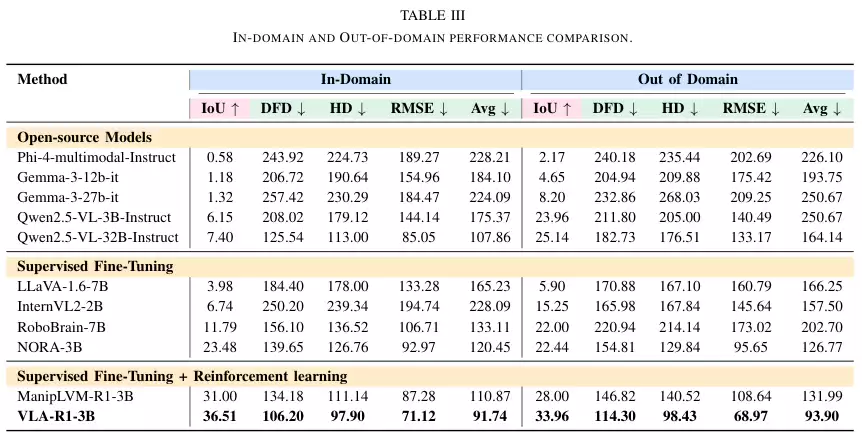

首先是在熟悉的领域内数据集(ShareRobot)上进行测试。这个数据集是专门为可供性感知和轨迹预测任务构建的,规模庞大,场景丰富。

实验结果非常清晰。那些通用的、强大的开源多模态模型,比如Gemma和Phi系列,在这些具身任务上表现不佳。尽管它们参数量巨大,但在定位精度(IoU)上得分低于10,轨迹预测的各项误差(DFD, HD, RMSE)也居高不下。这说明,通用的视觉语言能力并不能直接转化为精确的机器人操作能力。

经过监督微调(SFT)的基线模型,如RoboBrain和NORA,表现有所提升,IoU通常在5到25之间。这证明了针对性训练的有效性。

而VLA-R1-3B的表现则全面领先。它的IoU达到了36.51,轨迹误差的三项指标(DFD, HD, RMSE)分别为106.2, 97.9, 71.12。与同样经过强化学习训练的强基线ManipLVM-R1相比,VLA-R1的IoU提升了17.78%,轨迹误差整体降低了17.25%。

接着是更具挑战性的领域外(Out-of-Distribution, OOD)泛化能力测试。模型需要处理它在训练中从未见过的数据。结果显示,VLA-R1的优势更加明显。在可供性任务上,它的IoU达到了33.96。在轨迹预测任务上,三项误差指标甚至比领域内测试时还要低。这证明VLA-R1学到的不仅仅是死记硬背训练数据,而是真正掌握了可泛化的推理能力。

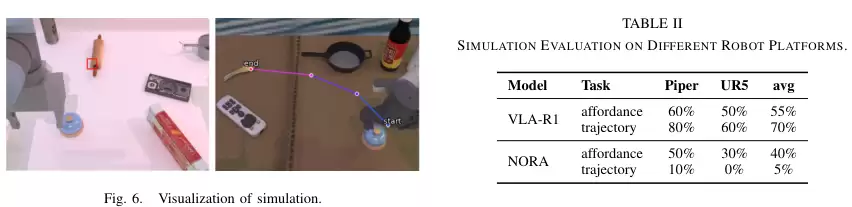

随后,实验进入了模拟环境。研究团队使用RoboTwin模拟器,在一个每次都会随机变化的桌面环境中测试模型的性能。他们测试了两种不同的机器人(Piper和UR5),以检验模型的跨平台通用性。

尽管模拟环境的变化比训练数据更大,VLA-R1依然表现出色。在可供性感知任务上,它的平均成功率(Success Rate, SR)为55%。在轨迹执行任务上,平均成功率更是达到了70%。相比之下,基线模型NORA的表现则差很多,尤其是在轨迹任务上,几乎完全失败。这证实了VLA-R1在动态变化的环境中,依然能保持强大的稳定性和泛化能力。

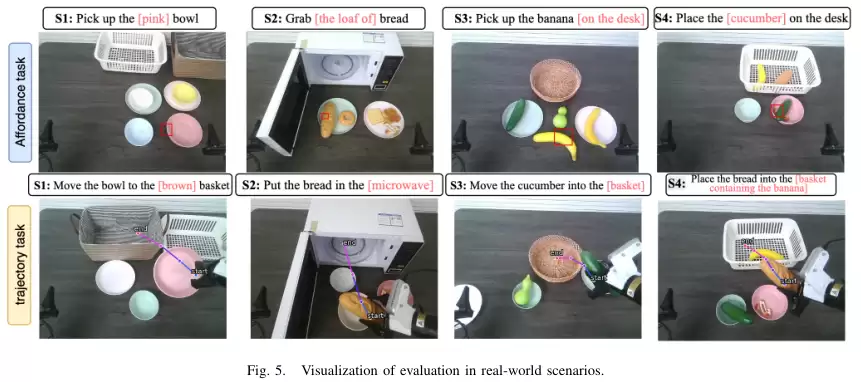

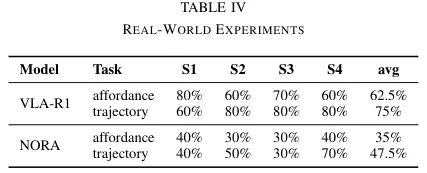

最后,也是最关键的,是真实世界实验。研究团队在真实的桌面上设置了四个典型场景,包括拾取特定颜色的碗、从多个相同水果中挑选一个、在有遮挡的厨房场景中操作,以及包含多种干扰物的混合场景。

在这些充满不确定性的真实环境中,VLA-R1再次证明了自己。在可供性感知任务上,它的平均成功率约为62.5%,在轨迹预测任务上,平均成功率高达75%。而基线模型NORA-3B在这两项任务上的成功率分别只有35%和47.5%。研究团队发现,颜色相近、位置变化等因素是导致错误的主要原因。即便如此,VLA-R1在失败的情况下,其预测也通常集中在目标物体附近,而不是完全离谱,显示出了一定的容错和自我纠正能力。

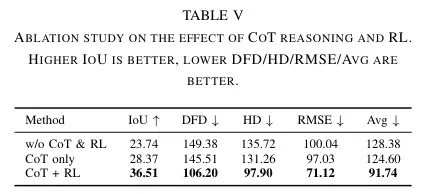

为了彻底搞清楚思维链(CoT)和强化学习(RL)各自的贡献,研究团队还进行了一项消融研究。他们测试了三种配置:没有CoT和RL的模型,只有CoT的模型,以及同时使用CoT和RL的完整版VLA-R1。

结果如表所示,每一步的改进都清晰可见。单独加入CoT,就能让模型的定位精度(IoU)从23.74提升到28.37,这说明思维链对于帮助模型理解属性、消除歧义至关重要。而当CoT和RL结合后,所有指标都获得了巨大提升。这完美地证明了两者是互补的:思维链提供了结构化的任务分解和推理框架,而强化学习则利用精细的奖励信号来打磨和完善具体的执行策略,最终实现了1+1>2的效果。

目前,所有的开发和验证工作都集中在单臂机器人上。未来,将这套方法扩展到更复杂的机器人平台,比如双臂协作机器人,或者能行走的四足机器狗,将是一个重要的研究方向。

这项研究清晰地表明,让机器人学会像人一样先思考再行动,是通往通用物理世界AI的必由之路。

免责声明

游乐网为非赢利性网站,所展示的游戏/软件/文章内容均来自于互联网或第三方用户上传分享,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系youleyoucom@outlook.com。

同类文章

谷歌AI转型实绩:传统业务焕新,为互联网企业带来增长新路径

谷歌母公司Alphabet近日公布了最新季度财报,总营收达1023 46亿美元,同比增长16%,超出华尔街预期超20亿美元。分业务线来看,各板块表现均优于市场预期,摊薄每股收益达2 87美元,盘后股

马斯克“硬刚”维基百科:人类知识运营的深层矛盾解析

埃隆·马斯克近期对维基百科发起多轮公开批评,并推出由人工智能驱动的在线百科项目GrokiPedia,引发两大知识平台的隔空交锋。面对科技巨头的挑战,维基百科在最新募捐公告中以独特方式作出回应,强调其

黄仁勋、周鸿祎共论AI:是伙伴非工具,推动经济与个体升级

在近期科技界关于人工智能(AI)发展的讨论中,两位科技行业领军人物对AI本质的认知出现了高度契合的观点。英伟达创始人黄仁勋与360集团创始人周鸿祎不约而同地提出,AI不应被简单定义为技术工具,而应被

谷歌CEO:全力押注生成式AI,Gemini下载量突破65亿次

在最新公布的季度财报中,科技巨头Alphabet交出了一份亮眼成绩单,公司第三季度营收成功突破千亿美元大关。在随后召开的财报电话会议上,首席执行官桑达尔·皮查伊着重阐述了公司对生成式人工智能的战略布

环球音乐与Udio和解:版权纠纷落幕,2026年推AI音乐平台

环球音乐集团(UMG)与人工智能音乐创作平台Udio近日宣布达成一项具有开创性的战略合作协议,这一举措在音乐行业引发广泛关注。此前,双方曾因版权问题陷入法律纠纷,此次合作不仅化解了矛盾,更开启了音乐

相关攻略

热门教程

更多- 游戏攻略

- 安卓教程

- 苹果教程

- 电脑教程