豆包是否可以本地部署 自主可控环境下运行豆包的技术路径说明

本文旨在解答关于豆包是否可以在本地环境下进行部署并实现自主可控运行的问题。目前,豆包主要以云服务形式提供,用户通过网络访问其功能。要在自主可控的环境下运行类似的大型语言模型能力,通常需要采用不同的技术路径,即在本地计算资源上部署可用的AI模型。本文将概述实现本地自主可控AI运行的通用技术路线和关键步骤,帮助理解其过程。

理解豆包的运行模式

豆包是基于大型语言模型的智能服务,其核心模型和计算资源部署在服务提供商的云端基础设施中。用户通过客户端或接口与云端服务进行通信和交互。这意味着,豆包的日常运行和技术控制權主要掌握在服务提供方。

实现自主可控本地AI的技术路径

要达到在自主可控环境下运行类似大型语言模型的能力,其技术路径不同于直接“安装”云服务。这通常涉及在拥有完全控制权的本地硬件上,部署并运行适配本地环境的AI模型。以下是实现这一目标的通用技术步骤说明:

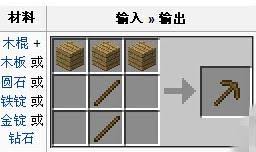

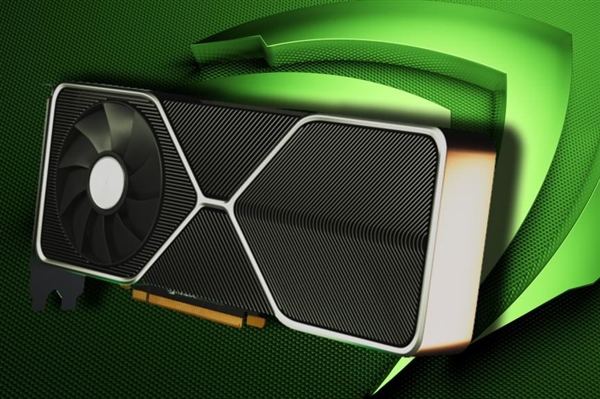

1、硬件资源准备:部署大型AI模型要求具备强大的本地计算能力,尤其是高性能的图形处理器(GPU)。GPU的显存容量是决定可加载模型规模和运行效率的关键要素。建议根据计划运行的模型大小选择合适的显卡。

2、软件环境配置:需要在本地操作系统上安装必要的软件栈,包括兼容的显卡驱动程序、用于模型推理的框架(如TensorFlow、PyTorch)或专门优化的本地推理引擎(例如针对消费者硬件的llama.cpp、Ollama等)。

立即进入“豆包AI人工智正式入口”;

立即学习“豆包AI人工智能在线问答入口”;

3、模型获取与选择:选择并获取适合本地部署的大型语言模型文件。目前社区提供了许多开源或允许本地使用的预训练模型,这些模型通常有不同的大小和量化版本,以适应不同的硬件能力。

4、模型加载与设置:使用选定的推理引擎或框架加载下载到本地的模型文件。在此过程中,通常需要进行一些配置,例如指定模型文件的路径、选择合适的量化精度以优化显存占用和推理速度。

5、模型执行与集成:启动推理过程,通过编程接口或命令行与本地加载的模型进行交互。可以根据具体需求,将模型能力集成到本地应用程序、自动化脚本或工作流程中,实现自主调用和控制。

本地自主可控运行的考量

在本地实现AI的自主可控运行,不仅是技术部署问题,还需要考虑数据隐私、系统安全、以及持续的资源消耗(如电力、散热)和维护成本。确保本地数据不外泄,运行环境不受外部干扰,是实现真正自主可控的关键环节。

免责声明

游乐网为非赢利性网站,所展示的游戏/软件/文章内容均来自于互联网或第三方用户上传分享,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系youleyoucom@outlook.com。

同类文章

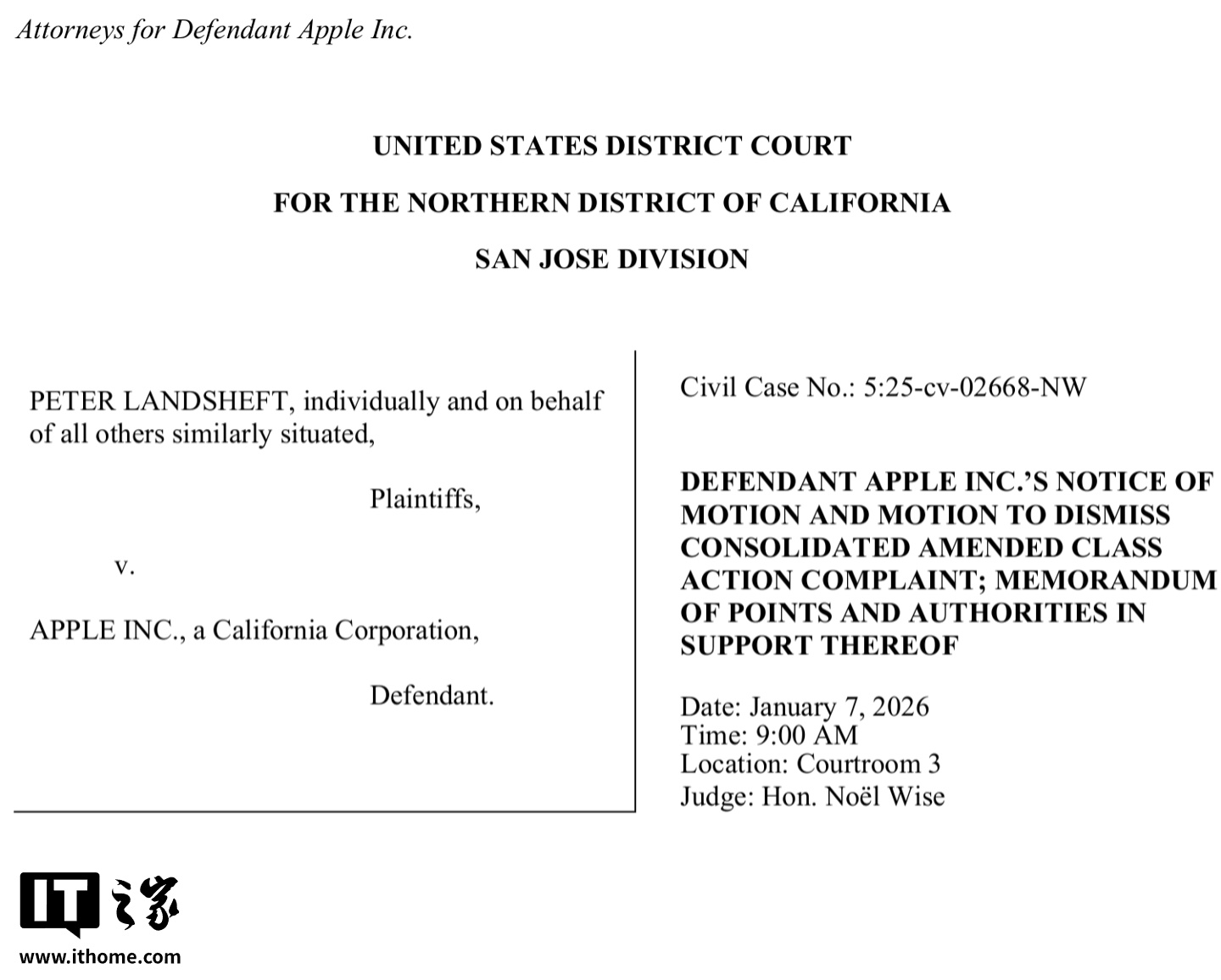

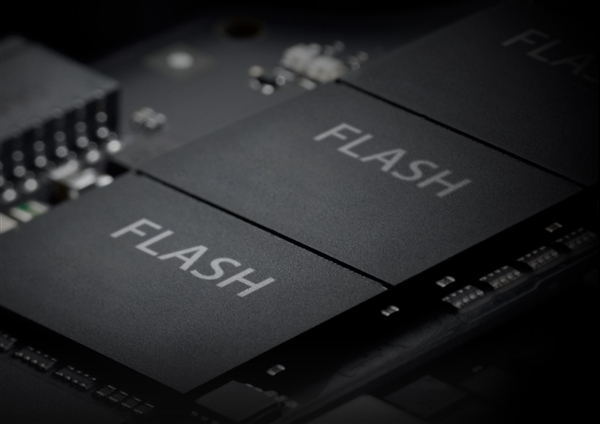

AI驱动存储芯片市场爆发,2027年或达3000亿规模

全球存储芯片市场正经历一场由人工智能(AI)需求主导的深刻变革。摩根大通分析师团队在最新报告中指出,云服务提供商对高性能内存的旺盛需求,正推动整个行业进入长期结构性增长通道。这场变革不仅重塑了DRA

真我GT8 Pro首发2K 144Hz京东方直屏

9月26日消息,真我realme官方正式宣布,真我GT8 Pro将联合京东方全球首发2K 144Hz“苍穹屏”,官方将其定位为“神级

OPPO Find X9首发4K实况照片 影像体验再升级

9月26日消息,OPPO宣布其全新Find X9系列手机将全球首发“直出4K超清实况照片”功能,这一创新技术标志着手机影像领域的一次

vivo X300系列重构移动影像体验,全链路创新开启场景化创作新时代

9月26日,vivo在“X系列蓝图影像技术沟通会”上揭晓全新影像战略,宣布以“场景解决方案”为核心构建开放生态,推动移动影像从工具属

OPPO Find X9红色限定版亮相,绒砂工艺重塑高端质感

9月26日消息,OPPO官方微博发布了全新的产品外观图,其中Find X9系列红色特别版首次亮相。这款采用全新红色设计的旗舰新机,以

相关攻略

热门教程

更多- 游戏攻略

- 安卓教程

- 苹果教程

- 电脑教程