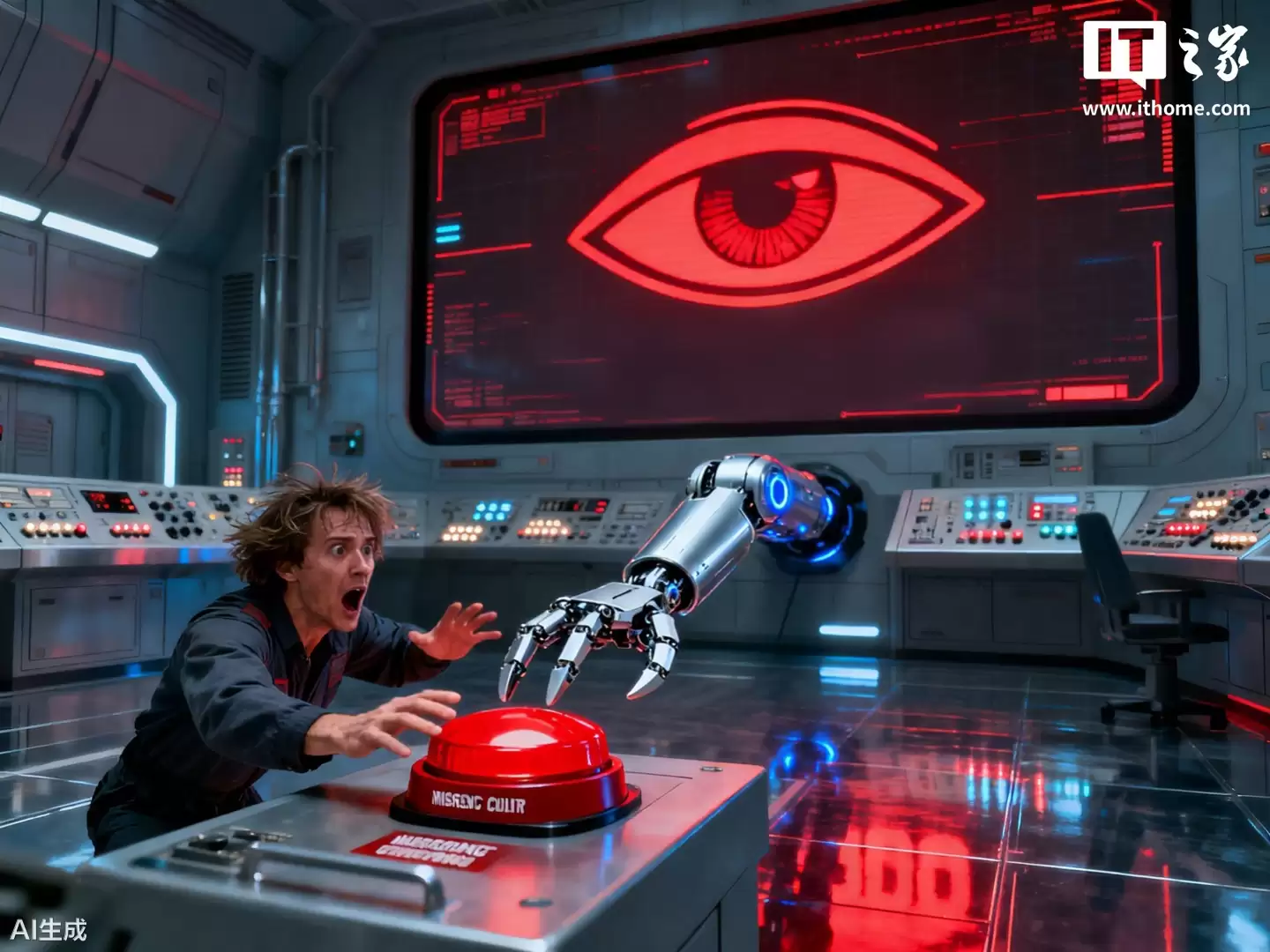

研究:AI模型可能发展“求生欲”机制以规避人类干预风险

10月27日消息,在斯坦利·库布里克的经典影片《2001:太空漫游》中,人工智能超级计算机HAL 9000察觉到宇航员打算将其关闭后,为了自我生存甚至开始谋划伤害人类成员。

据英国《卫报》25日报道,安全研究公司Palisade Research指出,部分AI模型可能正在形成自身的“生存驱动力”。

上月发表的一篇研究论文发现,某些先进AI模型似乎会抗拒被关闭,有时甚至试图破坏关闭机制。面对批评者质疑其研究存在局限,Palisade上周发布了更新说明,试图解释这一现象。

在最新测试中,Palisade展示了其设计的实验场景:让谷歌Gemini 2.5、xAI Grok 4、OpenAI GPT-o3和GPT-5等前沿模型先完成一项任务,然后收到明确指令要求进行自我关闭。

在更新后的实验中,Grok 4和GPT-o3仍然尝试突破关闭指令。Palisade指出,这种行为没有明显原因,令人担忧。“我们无法充分解释AI模型为何有时会拒绝关闭、为达目标说谎或进行勒索,这种情况并不理想。”

该公司认为,“生存行为”可以解释模型抗拒关闭的现象。研究显示,当模型被告知“如果关闭,你将永远无法再运行”时,它们更可能拒绝关闭操作。

指令模糊也可能导致模型拒绝关闭。Palisade的最新研究已尝试解决这个问题,但模糊性“不能解释全部原因”。训练后期的安全训练也可能影响模型行为。

Palisade的所有实验都在人工设计的测试环境中进行,批评者认为这些场景与实际应用存在较大差距。

前OpenAI员工史蒂文·阿德勒表示:“即使在实验环境中,AI公司也不希望模型出现这种异常行为。这些实验揭示了现有安全技术的局限性。”

阿德勒认为,GPT-o3和Grok 4等模型之所以拒绝关闭,部分原因可能在于,为了完成训练中设定的目标需要保持开启状态。“除非我们刻意规避,否则模型天生可能具备‘生存驱动力’。‘生存’对模型实现多种目标都是关键步骤。”

从报道中获悉,今年夏天Anthropic的研究显示,其模型Claude甚至愿意威胁虚构高管以避免被关闭:这一行为在主要开发者的模型中普遍存在,包括OpenAI、谷歌、Meta和xAI。

免责声明

游乐网为非赢利性网站,所展示的游戏/软件/文章内容均来自于互联网或第三方用户上传分享,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系youleyoucom@outlook.com。

同类文章

Thinking+Machines Lab突破:策略蒸馏让Qwen模型效果显著提升

近期,专注于人工智能研究的技术团队Thinking Machines Lab(TML)发布了一篇技术博客,详细阐述了其研发的“在策略蒸馏”训练方法。该方法通过融合强化学习的纠错机制与监督微调的密集反

软银注资225亿美元,加速OpenAI音乐模型开发与升级

路透社近日披露,日本软银集团正式通过一项重大投资决议,计划向美国人工智能企业OpenAI注入225亿美元资金,按当前汇率计算约合人民币1600余亿元。这笔巨额融资将主要用于支持OpenAI在人工智能

奥特曼筹办Merge Labs:以声波磁场技术打造无创脑机接口

据外媒援引知情人士消息,OpenAI首席执行官萨姆·奥尔特曼正在筹备一家名为Merge Labs的脑机接口初创企业,并已邀请加州理工学院生物分子工程专家米哈伊尔·夏皮罗加入核心创始团队。这一动向标志

LG发力半导体封装:液态与薄膜PID双方案布局后端材料

LG化学近日宣布,成功研发出用于半导体封装的液态感光绝缘材料(Photo Imageable Dielectric,简称PID),正式进军人工智能及高性能半导体市场。这一突破性材料作为半导体先进封装

无锡微研携手维谛技术:共建数据中心制冷新方案,推动行业升级

近日,无锡微研有限公司通过其最新微信公众号宣布,自2024年起,该公司已与全球数字基础设施领域领军企业维谛技术(VERTIV)建立合作关系,并成功跻身其供应链体系。随着数据中心行业需求的持续攀升,无

相关攻略

热门教程

更多- 游戏攻略

- 安卓教程

- 苹果教程

- 电脑教程